热点资讯

更多最新排行

热门排行

推荐排行

-

千文影视app

千文影视app一款很有趣的观看视频的软件!这款软件为各位伙伴带来了一系列精彩有趣的影··· -

千文影视app

千文影视app一款很有趣的观看视频的软件!这款软件为各位伙伴带来了一系列精彩有趣的影··· -

田半影视app

田半影视是一款专业的影视播放软件。田半影视拥有各种精彩的视频,包括热门资源、最新··· -

田半影视app

田半影视是一款专业的影视播放软件。田半影视拥有各种精彩的视频,包括热门资源、最新··· -

完美影视app

完美影视是一款十分精彩的看影视剧软件!这款软件汇集了当下最新最精彩的影视作品,用··· -

完美影视app

完美影视是一款十分精彩的看影视剧软件!这款软件汇集了当下最新最精彩的影视作品,用···

-

TV虫影视APP

TV虫影视APP是一款十分好用的特色手机追剧影视大全app,用户可以使用此款app观看各种有··· -

多瑙影院app

多瑙影院app是款很好用的影视播放工具,用户在app内可以看到各类影视资源,首页推荐有··· -

柠檬影视app

柠檬影视app,是您手掌心最强大的观影神器,简单好用超直接,观影免费无需等待,剧情超··· -

TV虫影视APP

TV虫影视APP是一款十分好用的特色手机追剧影视大全app,用户可以使用此款app观看各种有··· -

千文影视app

千文影视app一款很有趣的观看视频的软件!这款软件为各位伙伴带来了一系列精彩有趣的影··· -

TV虫影视APP

TV虫影视APP是一款十分好用的特色手机追剧影视大全app,用户可以使用此款app观看各种有···

-

手机淘宝

手机淘宝(iPhone版)是淘宝专为iPhone手机用户推出的满足其生活消费和线上购物需求的··· -

玲珑视频app

玲珑视频app是一款影视追剧软件,用户在这里可以找到很多的影视资源,很多的热门电视剧··· -

玲珑视频app

玲珑视频app是一款影视追剧软件,用户在这里可以找到很多的影视资源,很多的热门电视剧··· -

思古影视app

思古影视APP官方正版是一款影视剧很多的手机软件,这里的影视节目包含了电影和电视剧、··· -

大头影视app官方

大头影视app官方版里面的所有内容都是相当的不错,看剧的过程是会非常的到位,只要你能··· -

千禧影视app

千禧影视app是一款拥有海量影片资源的视频播放软件。用户可以在该软件上看到当前最新鲜···

小编推荐

软件下载

更多 >游戏下载

更多 >大家最爱

影视快讯

更多 >-

免费看电影,有这一个 APP就够了!

免费看电影,有这一个 APP就够了!虫虫影视是一款提供免费看高清精品影视的产品,可以免费在线看,可以免费下载,可以投屏到电视···

-

哪个app电影最全还免费

看电影app哪些软件最好手机观影app排行榜TOP10下载自从看电影软件的出现,只要下载看电影软件就能随时获得电影资讯以及电影资源,···

-

看综艺app哪些软件最好

看电影app哪些软件最好手机观影app排行榜TOP10下载自从看电影软件的出现,只要下载看电影软件就能随时获得电影资讯以及电影资源,···

-

看电视剧app哪些软件最好

看电影app哪些软件最好手机观影app排行榜TOP10下载自从看电影软件的出现,只要下载看电影软件就能随时获得电影资讯以及电影资源,···

-

看电影app哪些软件最好

看电影app哪些软件最好手机观影app排行榜TOP10下载自从看电影软件的出现,只要下载看电影软件就能随时获得电影资讯以及电影资源,···

-

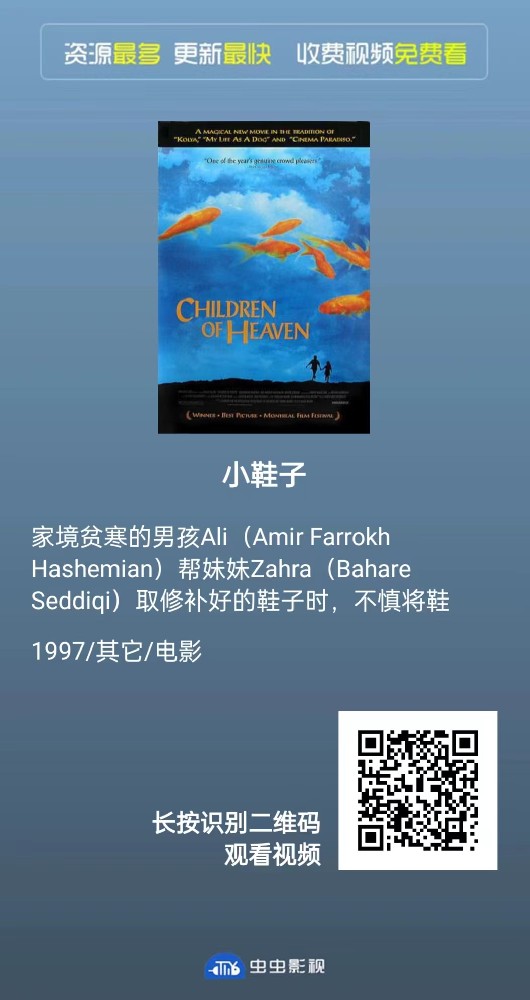

《小鞋子》在线高清完整版观看 !看免费资源-超清-无删减!!立即下载

可以下载看可以投屏看可以自己手机上看更多最新vip电影电视剧,你还不下载呀!这么牛P的app,一不小心就找不到了!